Transformer中的FFN(前馈神经网络)设计为先升维再降维的原因在于,升维操作可以引入更多的非线性特征,增强模型的表达能力;而随后的降维操作则有助于减少计算量和过拟合风险。这种设计使得模型既能捕获丰富的上下文信息,又能保持较高的计算效率。

本文目录导读:

Transformer模型在自然语言处理领域取得了巨大的成功,其中的关键组件之一便是Feed Forward Network (FFN),在FFN中,一种常见的操作是先进行升维,然后再进行降维,这种操作背后蕴含着怎样的原因和动机呢?本文将对此进行深入探讨。

背景知识

为了理解为什么Transformer的FFN需要先升维再降维,我们需要首先了解FFN的基本结构和Transformer模型的工作原理。

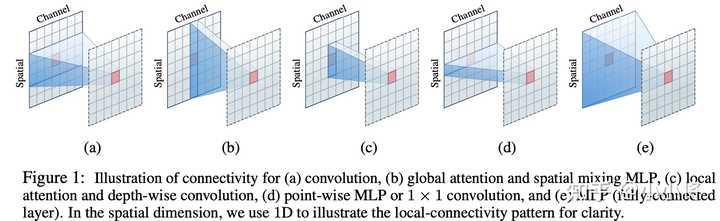

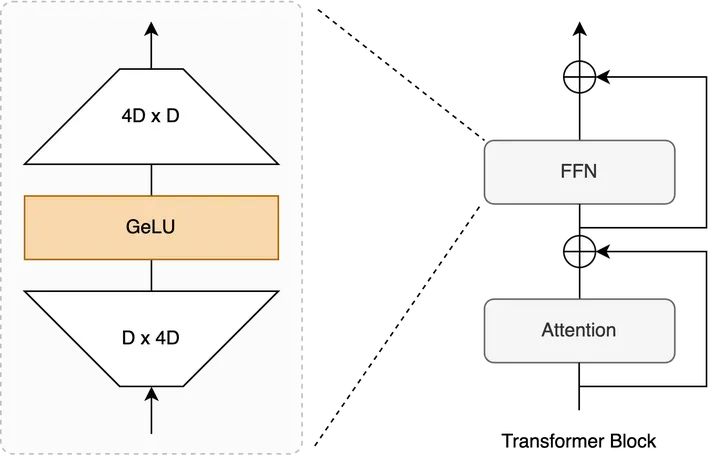

1、Feed Forward Network (FFN)

FFN是Transformer模型中的一个重要组件,主要负责实现输入数据的线性变换,FFN通常由多个线性层和激活函数(如ReLU)组成。

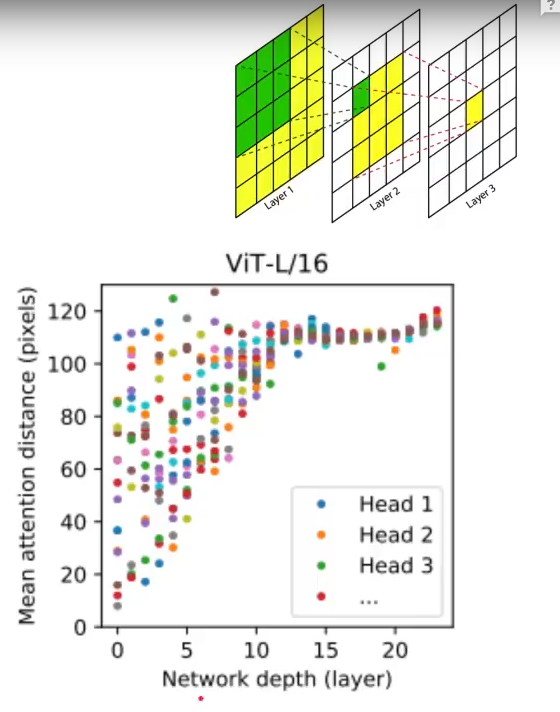

2、Transformer模型

Transformer模型基于自注意力机制,通过编码器(Encoder)和解码器(Decoder)实现序列数据的处理,在编码器和解码器中,FFN扮演着重要的角色,用于增强模型的表示能力。

FFN的升维与降维操作

在FFN中,输入数据首先进行升维操作,然后通过一系列线性变换和激活函数进行处理,最后进行降维操作,这种先升维再降维的操作模式背后蕴含着以下几个原因:

1、表示能力:升维操作可以扩大数据的表示空间,使模型能够捕捉到更丰富的特征,通过增加维度,我们可以为数据提供更多的自由度,使其在新的维度上表现出更多的变化,这对于模型的表示能力至关重要。

2、激活函数的作用:在升维后,我们可以利用激活函数(如ReLU)增加模型的非线性性,非线性性对于模型学习复杂的输入数据模式至关重要,通过激活函数,模型可以更好地捕捉数据的非线性关系。

3、降维的意义:经过升维和一系列线性变换及激活函数处理后,降维操作可以帮助模型回归到原始数据的维度,这种回归过程有助于模型学习到输入数据的本质特征,并去除冗余信息,降维还可以降低模型的计算复杂度,提高模型的运行效率。

为什么需要这种操作?

为什么Transformer的FFN需要采用这种先升维再降维的操作模式呢?这主要基于以下几个原因:

1、捕捉复杂特征:通过升维操作,FFN可以捕捉到输入数据的更多特征,这些特征可能分布在不同的维度上,通过扩大数据的表示空间,模型可以更好地学习这些特征。

2、非线性性的引入:激活函数(如ReLU)的引入使得模型具有更强的非线性性,这种非线性性有助于模型学习复杂的输入数据模式,从而提高模型的性能。

3、效率与性能的平衡:虽然升维操作会增加模型的计算复杂度,但通过合理的降维操作,我们可以平衡模型的计算效率和性能,降维操作可以去除冗余信息,降低模型的计算负担,同时保留关键特征,从而保证模型的性能。

4、与Transformer其他组件的协同:FFN作为Transformer模型的一部分,需要与其他组件(如自注意力机制)协同工作,通过先升维再降维的操作模式,FFN可以更好地与这些组件配合,提高整个模型的性能。

实验与验证

为了验证先升维再降维的操作模式在Transformer模型中的有效性,我们可以设计实验进行对比,实验可以包括以下几个步骤:

1、构建不同的FFN结构:分别构建先进行升维操作再进行降维操作的FFN结构,以及不进行升维操作的常规FFN结构。

2、训练模型:使用相同的训练数据和训练策略,对不同的FFN结构进行训练。

3、评估性能:使用相同的测试数据集,评估不同FFN结构的模型性能。

4、分析结果:对比实验结果,分析先升维再降维的操作模式对模型性能的影响。

本文探讨了为什么Transformer的FFN需要先进行升维再进行降维的原因,通过深入了解FFN的结构和Transformer模型的工作原理,我们发现这种操作模式有助于提高模型的表示能力、引入非线性性、平衡效率与性能以及与其他组件的协同工作,实验验证将进一步证明这种操作模式的有效性。

展望

我们可以进一步研究如何优化FFN的升维和降维操作,以提高Transformer模型的性能,还可以探索其他类型的FFN结构,以适应不同的任务和数据集,通过对FFN的深入研究,我们可以为自然语言处理领域带来更多的创新和突破。

京ICP备11000001号

京ICP备11000001号